"정규 분포"의 두 판 사이의 차이

Pythagoras0 (토론 | 기여) |

Pythagoras0 (토론 | 기여) |

||

| 2번째 줄: | 2번째 줄: | ||

* 고교 과정의 통계에서는 정규분포의 기본적인 성질과 정규분포표 읽는 방법을 배움. | * 고교 과정의 통계에서는 정규분포의 기본적인 성질과 정규분포표 읽는 방법을 배움. | ||

| − | * 평균이 <math>\mu</math>, 표준편차가 <math>\sigma</math>인 정규분포의 <math>N(\mu,\sigma^2)</math>의 확률밀도함수, 즉 가우시안은 다음과 같음이 알려져 있음.:<math>\frac{1}{\sigma\sqrt{2\pi}}\exp\left(-\frac{(x-\mu)^2}{2\sigma^2}\right)</math | + | * 평균이 <math>\mu</math>, 표준편차가 <math>\sigma</math>인 정규분포의 <math>N(\mu,\sigma^2)</math>의 확률밀도함수, 즉 가우시안은 다음과 같음이 알려져 있음.:<math>\frac{1}{\sigma\sqrt{2\pi}}\exp\left(-\frac{(x-\mu)^2}{2\sigma^2}\right)</math> |

* 아래에서는 이 확률밀도함수가 어떻게 해서 얻어지는가를 보임.(기본적으로는 가우스의 증명) | * 아래에서는 이 확률밀도함수가 어떻게 해서 얻어지는가를 보임.(기본적으로는 가우스의 증명) | ||

* 가우시안의 형태를 얻는 또다른 방법으로 [[드무아브르-라플라스 중심극한정리]] 를 참조. | * 가우시안의 형태를 얻는 또다른 방법으로 [[드무아브르-라플라스 중심극한정리]] 를 참조. | ||

| 10번째 줄: | 10번째 줄: | ||

* 오차 = 관측하려는 실제값 - 관측에서 얻어지는 값 | * 오차 = 관측하려는 실제값 - 관측에서 얻어지는 값 | ||

| − | * 오차의 분포를 기술하는 확률밀도함수 <math>\Phi</math>는 다음과 같은 성질을 만족시켜야 함. | + | * 오차의 분포를 기술하는 확률밀도함수 <math>\Phi</math>는 다음과 같은 성질을 만족시켜야 함. 1) <math>\Phi(x)=\Phi(-x)</math> 2)작은 오차가 큰 오차보다 더 나타날 확률이 커야한다. 그리고 매우 큰 오차는 나타날 확률이 매우 작아야 한다. 3) <math>\int_{-\infty}^{\infty} \Phi(x)\,dx=1</math> 4) 관측하려는 실제값이 <math>\mu</math> 이고, n 번의 관측을 통해 <math>x_ 1, x_ 2, \cdots, x_n</math> 을 얻을 확률 <math>\Phi(\mu-x_ 1)\Phi(\mu-x_ 2)\cdots\Phi(\mu-x_n)</math>의 최대값은 <math>\mu=\frac{x_ 1+x_ 2+ \cdots+ x_n}{n}</math>에서 얻어진다. |

* 4번 조건을 가우스의 산술평균의 법칙이라 부르며, 관측에 있어 실제값이 될 개연성이 가장 높은 값은 관측된 값들의 산술평균이라는 가정을 하는 것임. | * 4번 조건을 가우스의 산술평균의 법칙이라 부르며, 관측에 있어 실제값이 될 개연성이 가장 높은 값은 관측된 값들의 산술평균이라는 가정을 하는 것임. | ||

| − | ( | + | ;정리 (가우스) |

| − | |||

이 조건들을 만족시키는 확률밀도함수는 <math>\Phi(x)=\frac{h}{\sqrt{\pi}}e^{-h^2x^2}</math> 형태로 주어진다. 여기서 <math>h</math>는 확률의 정확도와 관련된 값임. (실제로는 표준편차와 연관되는 값) | 이 조건들을 만족시키는 확률밀도함수는 <math>\Phi(x)=\frac{h}{\sqrt{\pi}}e^{-h^2x^2}</math> 형태로 주어진다. 여기서 <math>h</math>는 확률의 정확도와 관련된 값임. (실제로는 표준편차와 연관되는 값) | ||

| − | |||

| − | + | ;증명 | |

<math>n=3</math>인 경우에 4번 조건을 만족시키는 함수를 찾아보자. | <math>n=3</math>인 경우에 4번 조건을 만족시키는 함수를 찾아보자. | ||

| 47번째 줄: | 45번째 줄: | ||

* 중심극한정리는 여러 과정을 거쳐 발전 | * 중심극한정리는 여러 과정을 거쳐 발전 | ||

| − | * 이항분포의 중심극한 정리 | + | * 이항분포의 중심극한 정리 |

| − | ** 라플라스의 19세기 초기 버전 | + | ** 라플라스의 19세기 초기 버전 |

확률변수 X가 이항분포 B(n,p)를 따를 때, n이 충분히 크면 X의 분포는 근사적으로 정규분포 N(np,npq)를 따른다 | 확률변수 X가 이항분포 B(n,p)를 따를 때, n이 충분히 크면 X의 분포는 근사적으로 정규분포 N(np,npq)를 따른다 | ||

** 드무아브르가 18세기에 발견한 것은 이항분포에서 확률이 1/2인 경우 | ** 드무아브르가 18세기에 발견한 것은 이항분포에서 확률이 1/2인 경우 | ||

| 61번째 줄: | 59번째 줄: | ||

** 정규분포의 밀도함수 형태를 물리적으로 얻을 수 있는 장치. | ** 정규분포의 밀도함수 형태를 물리적으로 얻을 수 있는 장치. | ||

** http://ptrow.com/articles/Galton_June_07.htm | ** http://ptrow.com/articles/Galton_June_07.htm | ||

| − | * 예전 독일 마르크화에는 가우스의 발견을 기려 정규분포곡선이 새겨짐 | + | * 예전 독일 마르크화에는 가우스의 발견을 기려 정규분포곡선이 새겨짐[[파일:1950958-Gauss-detail2.jpg]] |

| 73번째 줄: | 71번째 줄: | ||

* [[벤포드의 법칙]] | * [[벤포드의 법칙]] | ||

* [[최소자승법]] | * [[최소자승법]] | ||

| − | + | ||

==계산 리소스== | ==계산 리소스== | ||

| − | * [http://www.ruf.rice.edu/%7Elane/stat_sim/normal_approx/index.html 동전던지기 시뮬레이션] | + | * [http://www.ruf.rice.edu/%7Elane/stat_sim/normal_approx/index.html 동전던지기 시뮬레이션] |

** 자바애플릿 | ** 자바애플릿 | ||

| − | + | ||

==관련도서== | ==관련도서== | ||

| − | * Fischer, Hans , History of the Central Limit Theorem : | + | * Fischer, Hans , History of the Central Limit Theorem : From Laplace to Donsker |

* [http://www.amazon.com/History-Statistics-Measurement-Uncertainty-before/dp/067440341X/ref=sr_1_7?ie=UTF8&s=books&qid=1246720061&sr=1-7 The History of Statistics: The Measurement of Uncertainty before 1900] | * [http://www.amazon.com/History-Statistics-Measurement-Uncertainty-before/dp/067440341X/ref=sr_1_7?ie=UTF8&s=books&qid=1246720061&sr=1-7 The History of Statistics: The Measurement of Uncertainty before 1900] | ||

| − | * Excursions in calculus | + | * Excursions in calculus |

| − | ** 206~216p, | + | ** 206~216p, The law of errors |

| − | + | ||

==사전형태의 자료== | ==사전형태의 자료== | ||

| 99번째 줄: | 97번째 줄: | ||

==에세이== | ==에세이== | ||

| − | * | + | * http://math.stackexchange.com/questions/28558/what-do-pi-and-e-stand-for-in-the-normal-distribution-formula |

| − | + | * Pearson, Karl. "Historical note on the origin of the normal curve of errors." Biometrika (1924): 402-404. http://biomet.oxfordjournals.org/cgi/reprint/16/3-4/402.pdf | |

| − | + | ||

| − | |||

==관련기사== | ==관련기사== | ||

| − | * [http://www.hani.co.kr/arti/science/kistiscience/315218.html 과학자들의 진실게임 - 그 법칙은 내꺼야!] | + | * [http://www.hani.co.kr/arti/science/kistiscience/315218.html 과학자들의 진실게임 - 그 법칙은 내꺼야!] |

| − | ** | + | ** 과학에서 최초의 발견자와 크레딧 논쟁 사례 |

| − | ** 한겨레, 2008-10-10 | + | ** 한겨레, 2008-10-10 |

| − | * [http://news.naver.com/main/read.nhn?mode=LPOD&mid=etc&oid=042&aid=0000010241 [재미있는 과학이야기] 통계의 기본원리 ② 가우스 분포] | + | * [http://news.naver.com/main/read.nhn?mode=LPOD&mid=etc&oid=042&aid=0000010241 [재미있는 과학이야기] 통계의 기본원리 ② 가우스 분포] |

** 주간한국, 2008-01-07 | ** 주간한국, 2008-01-07 | ||

| − | * | + | * 기사 검색 (키워드 수정) |

** [http://news.search.naver.com/search.naver?where=news&x=0&y=0&sm=tab_hty&query=%EC%A0%95%EA%B7%9C%EB%B6%84%ED%8F%AC http://news.search.naver.com/search.naver?where=news&x=0&y=0&sm=tab_hty&query=정규분포] | ** [http://news.search.naver.com/search.naver?where=news&x=0&y=0&sm=tab_hty&query=%EC%A0%95%EA%B7%9C%EB%B6%84%ED%8F%AC http://news.search.naver.com/search.naver?where=news&x=0&y=0&sm=tab_hty&query=정규분포] | ||

| − | + | ||

==블로그== | ==블로그== | ||

| − | * 피타고라스의 창 | + | * 피타고라스의 창 |

** [http://bomber0.byus.net/index.php/2008/07/06/680 드무아브르의 중심극한정리(i)] | ** [http://bomber0.byus.net/index.php/2008/07/06/680 드무아브르의 중심극한정리(i)] | ||

** [http://bomber0.byus.net/index.php/2008/07/12/686 드무아브르의 중심극한정리(ii) : 스털링이 가져간 영광] | ** [http://bomber0.byus.net/index.php/2008/07/12/686 드무아브르의 중심극한정리(ii) : 스털링이 가져간 영광] | ||

| 124번째 줄: | 121번째 줄: | ||

** [http://bomber0.byus.net/index.php/2008/07/14/688 드무아브르의 중심극한정리(iv) : 가우시안의 눈부신 등장] | ** [http://bomber0.byus.net/index.php/2008/07/14/688 드무아브르의 중심극한정리(iv) : 가우시안의 눈부신 등장] | ||

| − | + | ||

==동영상== | ==동영상== | ||

| − | |||

* [http://www.youtube.com/watch?v=9tTHST1sLV8 Quincunx - The Probability Machine] | * [http://www.youtube.com/watch?v=9tTHST1sLV8 Quincunx - The Probability Machine] | ||

| − | |||

2014년 4월 12일 (토) 19:14 판

개요

- 고교 과정의 통계에서는 정규분포의 기본적인 성질과 정규분포표 읽는 방법을 배움.

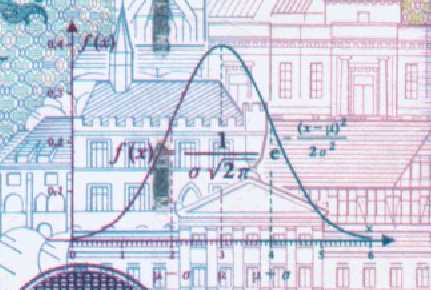

- 평균이 \(\mu\), 표준편차가 \(\sigma\)인 정규분포의 \(N(\mu,\sigma^2)\)의 확률밀도함수, 즉 가우시안은 다음과 같음이 알려져 있음.\[\frac{1}{\sigma\sqrt{2\pi}}\exp\left(-\frac{(x-\mu)^2}{2\sigma^2}\right)\]

- 아래에서는 이 확률밀도함수가 어떻게 해서 얻어지는가를 보임.(기본적으로는 가우스의 증명)

- 가우시안의 형태를 얻는 또다른 방법으로 드무아브르-라플라스 중심극한정리 를 참조.

'오차의 법칙'을 통한 가우시안의 유도

- 오차 = 관측하려는 실제값 - 관측에서 얻어지는 값

- 오차의 분포를 기술하는 확률밀도함수 \(\Phi\)는 다음과 같은 성질을 만족시켜야 함. 1) \(\Phi(x)=\Phi(-x)\) 2)작은 오차가 큰 오차보다 더 나타날 확률이 커야한다. 그리고 매우 큰 오차는 나타날 확률이 매우 작아야 한다. 3) \(\int_{-\infty}^{\infty} \Phi(x)\,dx=1\) 4) 관측하려는 실제값이 \(\mu\) 이고, n 번의 관측을 통해 \(x_ 1, x_ 2, \cdots, x_n\) 을 얻을 확률 \(\Phi(\mu-x_ 1)\Phi(\mu-x_ 2)\cdots\Phi(\mu-x_n)\)의 최대값은 \(\mu=\frac{x_ 1+x_ 2+ \cdots+ x_n}{n}\)에서 얻어진다.

- 4번 조건을 가우스의 산술평균의 법칙이라 부르며, 관측에 있어 실제값이 될 개연성이 가장 높은 값은 관측된 값들의 산술평균이라는 가정을 하는 것임.

- 정리 (가우스)

이 조건들을 만족시키는 확률밀도함수는 \(\Phi(x)=\frac{h}{\sqrt{\pi}}e^{-h^2x^2}\) 형태로 주어진다. 여기서 \(h\)는 확률의 정확도와 관련된 값임. (실제로는 표준편차와 연관되는 값)

- 증명

\(n=3\)인 경우에 4번 조건을 만족시키는 함수를 찾아보자.

\(\Phi(x-x_ 1)\Phi(x-x_ 2)\Phi(x-x_ 3)\)의 최대값은 \(x=\frac{x_ 1+x_ 2+ x_ 3}{3}\) 에서 얻어진다.

따라서 \(\ln \Phi(x-x_ 1)\Phi(x-x_ 2)\Phi(x-x_ 3)\) 의 최대값도 \(x=\frac{x_ 1+x_ 2+ x_ 3}{3}\) 에서 얻어진다.

미분적분학의 결과에 의해, \(x=\frac{x_ 1+x_ 2+ x_ 3}{3}\) 이면, \(\frac{\Phi'(x-x_ 1)}{\Phi(x-x_ 1)}+\frac{\Phi'(x-x_ 2)}{\Phi(x-x_ 2)}+\frac{\Phi'(x-x_ 3)}{\Phi(x-x_ 3)}=0\) 이어야 한다.

\(F(x)=\frac{\Phi'(x)}{\Phi(x)}\) 으로 두자.

\(x+y+z=0\) 이면, \(F(x)+F(y)+F(z)=0\) 이어야 한다.

1번 조건에 의해, \(F\) 는 기함수이다.

따라서 모든 \(x,y\) 에 의해서, \(F(x+y)=F(x)+F(y)\) 가 성립한다. 그러므로 \(F(x)=Ax\) 형태로 쓸수 있다.

이제 적당한 상수 \(B, h\) 에 의해 \(\Phi(x)=Be^{-h^2x^2}\) 꼴로 쓸 수 있다.

모든 \(n\)에 대하여 4번조건이 만족됨은 쉽게 확인할 수 있다. (증명끝)

역사

- 중심극한정리는 여러 과정을 거쳐 발전

- 이항분포의 중심극한 정리

- 라플라스의 19세기 초기 버전

확률변수 X가 이항분포 B(n,p)를 따를 때, n이 충분히 크면 X의 분포는 근사적으로 정규분포 N(np,npq)를 따른다

- 드무아브르가 18세기에 발견한 것은 이항분포에서 확률이 1/2인 경우

- 드무아브르-라플라스 중심극한정리 의 유도는 해당 항목을 참조.

- 수학사 연표

재미있는 사실

- 정규분포와 중심극한정리에 대한 이해는 교양인이 알아야 할 수학 주제의 하나

- Galton's quincunx

- 정규분포의 밀도함수 형태를 물리적으로 얻을 수 있는 장치.

- http://ptrow.com/articles/Galton_June_07.htm

- 예전 독일 마르크화에는 가우스의 발견을 기려 정규분포곡선이 새겨짐

관련된 항목들

계산 리소스

- 동전던지기 시뮬레이션

- 자바애플릿

관련도서

- Fischer, Hans , History of the Central Limit Theorem : From Laplace to Donsker

- The History of Statistics: The Measurement of Uncertainty before 1900

- Excursions in calculus

- 206~216p, The law of errors

사전형태의 자료

- http://ko.wikipedia.org/wiki/중심극한정리

- http://ko.wikipedia.org/wiki/정규분포

- http://en.wikipedia.org/wiki/normal_distribution

- http://en.wikipedia.org/wiki/Central_limit_theorem

- http://viswiki.com/en/central_limit_theorem

- 다음백과사전 http://enc.daum.net/dic100/search.do?q=오차의법칙

에세이

- http://math.stackexchange.com/questions/28558/what-do-pi-and-e-stand-for-in-the-normal-distribution-formula

- Pearson, Karl. "Historical note on the origin of the normal curve of errors." Biometrika (1924): 402-404. http://biomet.oxfordjournals.org/cgi/reprint/16/3-4/402.pdf

관련기사

- 과학자들의 진실게임 - 그 법칙은 내꺼야!

- 과학에서 최초의 발견자와 크레딧 논쟁 사례

- 한겨레, 2008-10-10

- [재미있는 과학이야기 통계의 기본원리 ② 가우스 분포]

- 주간한국, 2008-01-07

- 기사 검색 (키워드 수정)

블로그

- 피타고라스의 창